1. 引言

现代化高科技战争中,情报侦察是决定后续决策行动的先行步骤。在隐蔽自身为前提的侦察行动中,侦察人员不可避免会在黎明、傍晚、雾天、阴天等低照度环境下实施侦察。此时由侦察设备获取的影像呈现出对比度低、色彩失真、噪声高等低照度特性,极大地影响侦察人员对目标的有效发现和辨别,而能否在低照度环境下快速地发现并辨别敌我目标,直接影响战场主动权,甚至决定战争的胜负。当然,战场上可以通过发射各类照明弹来照亮作战区域,但是在复杂多变的作战场景下不仅照明时长、范围有限,且同时为敌我提供照明,不利于隐蔽自身。因此,如何在低照度条件下提高己方作战人员对作战环境的感知能力是值得研究的一个重要问题。

此外,在民用领域中,在照度不足的建筑物内部、施工坑道或隧道等场所作业时,如果没有有效感知周围环境,也容易出现各类事故,造成不可预料的灾难。因此,研究低照度图像增强具有重要的现实价值和意义。

为了提高人员在低照度环境下的视觉感知能力,本文设计并实现了一种可穿戴的低照度视觉增强感知设备。该设备通过采用低成本的笔筒式摄像头、嵌入式开发板及头戴显式器等硬件器材,制作了一个可穿戴的低照度视觉增强设备;同时,通过在嵌入式开发板上部署自标定增强算法可实现对低照度影像的有效增强,算法运行达到超实时处理速度。

2. 相关工作

低照度视觉增强设备的核心是低照度图像增强,该技术一直是计算机视觉领域的研究热点之一。经典方法主要有基于空域的方法和基于频域的方法。其中,基于空域的方法以图像中的像素点为处理对象,直接对图片的像素值进行操作,如直方图均衡等 [1] ,该方法操作相对简单,处理速度快,在锐化方面效果明显,但在增强、降噪同时会使图像边缘和细节产生模糊;基于频域的方法法则将图像转换到频域进行操作,该方法操作相对复杂,计算速度慢,且会出现振铃效应。此外,基于Retinex模型的方法 [2] [3] 将低照度图像分解为反射分量和照明分量,其中反射分量就是要增强的结果,该方法思想简单、且有较强的原理保障,被广泛应用在低照度增强研究中。

2017年,第一个基于深度学习的低照度增强方法LLNet [4] 取得了惊人的效果,采用叠加稀疏去噪自编码器的变体,并对低照度图像进行增亮和去噪。与传统方法相比,深度学习的方法有更好的准确性、鲁棒性和速度。根据学习策略的不同,可分为监督学习方法、半监督学习方法、无监督学习方法、强学学习方法、零样本学习方法等 [5] 。其中,监督学习方法中有对LLNet改进的方法,如MBLLEN [6] ,EEMEFN [7] 等方法;也有基于深度Retinex的方法,如Retinex-Net [8] 、LightenNet [9] 、KinD [10] ;前面的方法都是采用合成数据进行的模型训练,对真实数据缺乏泛化能力,为此研究者构建了SID [11] 等真实的低光照图像数据集,对应提出很多有效解决实际低照度增强的方法,如MFFNet [12] 、注意力曝光融合网络 [13] 等。

监督学习通常采用成对数据训练深度学习模型,会存在过拟合导致泛化能力下降的问题。为此,EnlightenGAN [14] 等无监督学习方法被提出,该方法采用U-Net作为生成器,采用全局和局部判别器来确保增强的结果与真是光照图像。类似的还有基于改进CycleGAN进行煤矿井下低照度图像的增强,解决了井下图像细节损失过多、图像色彩失真的情况 [15] 。

半监督学习结合了监督学习和无监督学习的优势,如深度递归波段网络(DRBN) [16] ,先在监督学习下恢复增强图像的线性波段表示,再通过基于无监督对抗学习的可学习线性变换对给定波段进行重新组合,获得改进的波段表示。此外,还有零样本学习方法,如ZeroDCE [17] 、基于双重迭代的方法 [18] ;强学学习方法,如DeepExposure [19] 等。

综上所述,监督学习方法的研究较其他类方法更多,效果相对也较好,但是无监督学习、半监督学习、零样本学习、强化学习等方法避免了监督学习面临的困难和局限,逐渐展现出更好的性能。特别是,2022年由大连理工大学团队提出了自校准照明(Self-Calibrated Illumination, SCI)模型 [20] ,通过权重共享的照明学习和自校准模块,实现了快速、灵活、鲁棒的低照度图像增强,有效提升了视觉质量和计算效率。因此,设备引入该模型进行低照度图像的效果增强。

3. 可穿戴低照度视觉增强设备

3.1. 可穿戴视觉增强设备架构

所设计可穿戴低照度视觉增强设备的架构如图1所示,主要包括图像采集模块、嵌入式算法处理模块、显示模块、可穿戴搭载模块、电源模块等组成。

设备通过图像采集模块从外部环境感知成像,经USB数据线传入嵌入式算法处理模块,并经过其中的低照度视觉增强算法增强后,通过HDMI数据线输出到显式模块,供用户观测。其中,电源模块对嵌入式算法处理模块进行直接供电,而图像采集模块和显式模块则由嵌入式算法处理模块进行间接供电,图像采集模块、显式模块、嵌入式算法处理模块和电源模块均搭载于可穿戴搭载模块上。

考虑到设备的可穿戴、轻便性和灵活度,可穿戴搭载模块采用头盔及腰带或背包构成,便于穿戴和搭载其他模块;图像采集模块采用体积小、重量轻的笔筒式摄像头,由USB线直接连入嵌入式算法处理模块;显式模块采用Vufine+单目显示器,通过翻转板连接于头盔上,输入信号由嵌入式算法处理模块的HDMI线传入;嵌入式算法处理模块采用Jetson Nano提供处理平台。

设备最核心是嵌入式算法处理模块,既通过USB、HDMI连接图像采集模块和显式模块,又负责低照度图像增强算法的执行。Jetson Nano开发板具有体积小、能耗低、算力强等优势特点,且对人工智能算法支持友好,能高效运行现代神经网络并处理来自高分辨率传感器的数据。

3.2. 低照度视觉增强模型

3.2.1. SCI模型思想

设备引入最新的自校准照明模型SCI [20] 对低照度图像进行视觉增强,该模型基于Retinex理论进行低照度图像增强建模,假设实际低照度图像可分解为理想图像与照明度两个分量,即,因此若能估计照明度,则可由恢复出理想图像。具体地,SCI模型通过构建一个由多个残差网络模块且权重共享迭代的自校准模块组成,并在无监督训练损失的监督下进行学习,实现了快速、灵活和稳健的低照度图像增强。

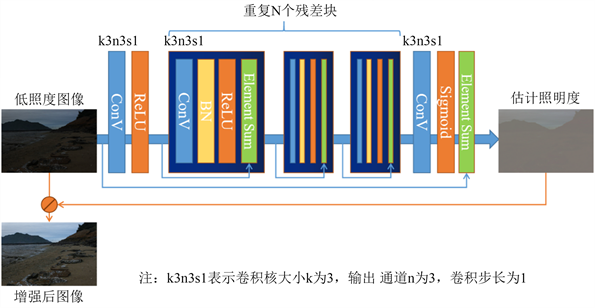

图2展示了SCI模型预测框架。输入低照度图像经过SCI模型自校准模块可以获得估计的照明度,由得到增强后的图像。其中,估计照明度采用了一个多层卷积神经网络,其中核心操作为重复N个权重贡献的残差块构成,最后由Sigmoid函数将输出值尽可能映射到0~1范围内,与已经归一化的输入图像进行元素求和,获得对图像照明度的估计。整个网络扮演了一个对原始图像求照度图与实际图像残差的角色,这种求残差的方式可以保障计算结果更精确和稳定。

Figure 2. SCI model prediction framework

图2. SCI模型预测框架

3.2.2. SCI模型与训练

为了学习到更加精准的照明度估计模块参数,SCI模型设计了一个权重共享的自校准模块和照度估计模块。具体通过如下迭代过程来对照明度图像进行有效估计:

(1)

(2)

其中,式(1)为自校准模块,

为第t个阶段的输入,

为校准后的输出,

为带参数

的映射算子操作;式(2)为照度估计模块,

为第t个阶段的输入,

为估计的照度输出,

为带参数

的映射算子操作。

开始时

,通过不断迭代式(1)和式(2),完成对照度的有效估计。自校准模块通过在每个阶段的将低照度图像

的信息包含进入,实现对照度

的校准并作为照度估计模块的转换输入。

的参数

和

的参数

为不同的阶段共享,可以极大地减少参数量,且保证在测试时仅需要一个照度估计模块的迭代阶段即可完成照度估计,极大地加速了推理速度。

为了有效学习映射算子

和

的参数,构建了保证度损失和平滑度损失:

(3)

(4)

其中,式(3)为保真度损失,保证

阶段补充光照和t阶段输入光照之间的像素级一致性,T为总阶段数;式(4)为平滑度损失,保证小的相邻块之间的像素变化更加平滑自然,M是像素总数,

表示第i个像素在其5 × 5窗口邻域内的像素集合,

表示第i个像素与邻域内第j个像素之间的权重。

综合保证度损失和平滑度损失得到总损失:

(5)

其中,

和

是对应的损失平衡参数。整个学习过程无需任何监督信息,属于无监督学习。

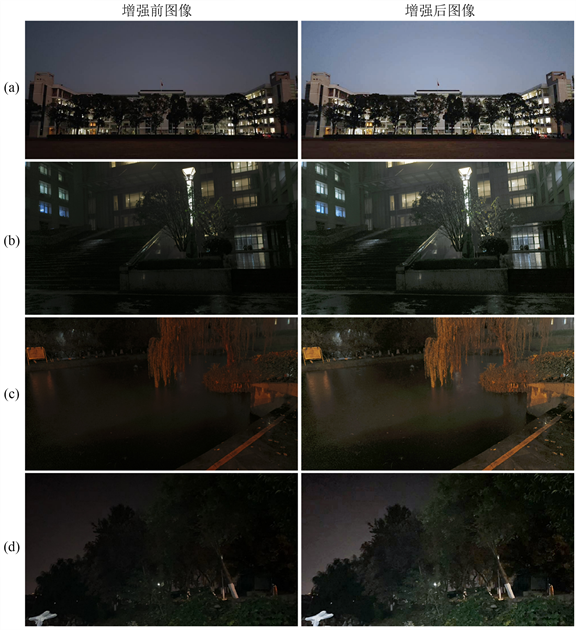

Figure 3. Before and after enhancement under low light conditions at dusk

图3. 黄昏弱光条件下景物增强前后对比图

4. 实验结果与分析

为了验证设备的性能和效果,实验对设备对低照度条件下的不同景物增强效果进行测试。包括:黄昏弱光条件下的景物增强,夜间非均匀光照条件下的景物增强,室内弱光条件下的景物增强,以及其他光照不足条件下的景物增强。

测试1:黄昏条件下的景物增强测试,测试效果如图3所示。图3(a)和图3(b)主要是建筑物,对比增强前后可以发现,经过增强的图像可以更加清晰地辨明建筑的棱角,特别是图3(b)中左侧建筑物的窗户、小区围栏、道路上的电动车等变得更清晰;图3(c)是建筑物和自然树叶的混合场景,增强后的建筑物和树叶细节更清晰;图3(d)自然场景经过增强后绿色植被的叶子显得更加突出。

测试2:夜间非均匀照明条件下的景物增强,测试效果见图4。图4(a)和图4(b)中建筑物内灯光虽然具有一定的照度,但距离较远或难以直射的区域亮度较低,难以辨别清楚具体内容,经过增强可以发现,图像建筑物细节更清晰,特别是图4(b)中楼宇门口的挡雨顶棚、楼梯等变得更清晰;图4(c)中道路、垂柳、及道路前的路滑带植被经过增强,细节更加清晰;图4(d)中自然树木在远处灯光下很难看清,经过增强后树叶等植被细节显得更加突出。

Figure 4. Before and after enhanced view under non-uniform lighting at night

图4. 夜间非均匀照明条件下景物增强前后对比图

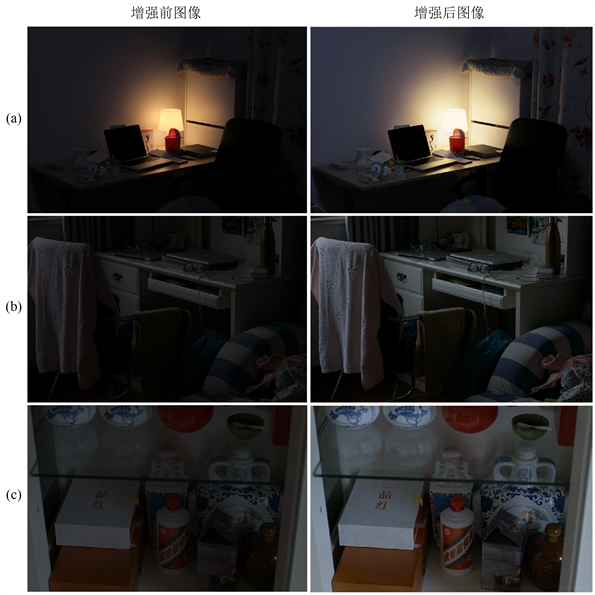

测试3:室内弱光条件下的景物增强,测试效果见图5。图5(a)中的台灯为室内提供了一定强度的光照,但是灯光较为昏暗,经过增强后台灯的光照较为明亮,同时桌面左侧的水杯与牛奶盒的细节变得更加的清晰;图5(b)和图5(c)中室内虽然有一定的光照,但不存在光照直射且光照强度较低,难以辨别清楚具体内容,经过增强可以发现,室内物品的细节更加的清晰,特别是图5(b)中桌上的电脑和桌下的毛巾等变得更清晰。

Figure 5. Before and after enhancement of the scene under low light conditions indoors

图5. 室内弱光条件下的景物增强前后对比图

测试4:其他光照不足条件下的景物增强,测试效果见图6。图6(a)为暴雨弱光条件下的景物,增强后的背景中的场所、人物的更加清晰可辨,还原出很多暗处的细节;图6(b)中人物独照在增强前,人体上半身、人脸、背景植被等几乎看不清,经过增强可以发现,虽然总体环境有一定的模糊,但是人脸、发饰等背光阴影部分的细节展示更明显,背景植被的远近层次感更清晰;图6(c)中快速运动的摩托车及车手经过增强后可以更加清晰的看到快速运动的背景,且任务细节更加清晰。

此外,我们还对模型在Jetson Nano设备上的性能进行了测试,采用5V功率运行模型,测试720P视频处理速度达到31.6帧/秒;为了对比,我们在无GPU的普通PC机上(CPU为AMD5 Ryzen5 6600H,主频3.3 GHz),对应测试速度仅为7.6帧/秒。由此可以发现,设备在GPU加速条件下达到了超实时的处理速度,且具有远超不带GPU的普通PC机的计算性能。

Figure 6. Before and after enhancement in other low light conditions

图6. 其他光照不足条件下的景物增强前后对比图

5. 总结

我们研究开发了一套可穿戴视觉增强感知设备,通过图像采集设备采集图像,采用弱光图像增强算法对实时图像进行增强处理,改良了图像的质量,使隐藏在黑暗中的信息变得可见,实现快速、灵活和稳健的弱光图像增强。

该设备辅助增强人对低照度环境的感知能力,具有广泛的应用场景。在野战条件下,夜间光源较少,不利于抵近侦察人员的目标观测。在不清楚敌方是否处于埋伏状态的情况下,如果使用照明设备,极易暴露自身位置。相较于目前已有的单兵侦察装备,该设备能够更好显示出夜间隐藏在黑暗中的细节。佩戴该设备能有效提升单兵夜间侦察能力,降低暴露风险,从而牢牢掌握战场主动权。

基金项目

陆军工程大学学员科技创新基金项目。

NOTES

*通讯作者。