1. 引言

高级驾驶辅助系统要求车辆具有应对极端情况和全天候环境的能力 [1],由于单传感器在相关场景下的性能存在局限,自动驾驶汽车通常配备不同类型的传感器。多源传感器融合可以利用不同传感器的信息进行互补,提升感知系统的鲁棒性和安全性,但是同时也给设计环境感知系统带来了新的挑战。目前,车辆环境感知常用激光雷达和视觉融合的方案,但是由于激光雷达成本高昂,且摄像头和激光雷达均在恶劣天气下性能衰减明显,也都无法提供目标速度信息,因此使用场景受限。对于毫米波雷达和摄像头的组合,其可以在获得目标丰富的语义信息的同时,感知物体的距离和速度。与摄像头信息相比,毫米波雷达的检测性能受极端天气和光照的影响较小,可以全天候工作,且信息处理所需算力更低,距离和径向速度估计更精确。而摄像头在具有更高的角分辨率和检测精度的同时,可以提供目标轮廓、纹理和颜色分布等语义信息,从而帮助目标分类 [2]。

由于摄像头图像数据和毫米波雷达点云数据模态差异很大,因此,如何有效融合多模态信息是一个很大的挑战。现有多模态信息融合方案主要在数据级、特征级和决策级三个方向进行。其中,决策级融合是目前主流信息融合方案。决策级融合首先对多源传感器分别进行信息处理,即先将毫米波雷达信息处理成一个包含物体速度和距离等信息的目标列表 [3] [4],并将视觉信息执行目标检测算法生成包含2D位置的目标列表。之后,对多源传感器目标列表信息进行滤波匹配,融合决策信息 [5]。当前决策融合主流滤波算法包括贝叶斯理论 [6] [7]、卡尔曼滤波算法 [8] [9] [10]、模糊子集理论方法和基于证据理论的推理方法 [11] 等。此外,文献 [12] [13] 使用雷达信息来验证视觉的检测结果。决策级融合算法可以减小对单传感器感知结果的依赖,增强系统鲁棒性。但是由于其未充分利用多源传感器不同模态的互信息,因此,并不能显著地提升系统性能。此外,在特征级进行多模态信息融合的方案也被广泛提出。基于卷积神经网络的特征级融合常通过将雷达检测信息转化为图像形式,使用额外的雷达输入分支来辅助目标检测模型对图像特征信息进行学习。特征融合可以使用级联和元素相加等方法 [14],级联将图像特征矩阵和雷达点云特征矩阵进行连接,形成多通道矩阵。而元素相加将多源特征矩阵合并为一个特征矩阵。此外,文献 [15] 使用空间注意力融合(Space Attention Fusion, SAF)机制生成注意力权重矩阵,融合多源传感器特征,提升检测性能。对于多源传感器的数据级融合,现有算法常利用毫米波雷达生成图像的可分辨单元,再从融合数据中提取信息,用于进一步决策。但由于毫米波雷达点云的稀疏性,现有多源异构融合算法存在融合效率低,雷达信息表达不充分等问题 [16]。

针对上述问题,本文提出了一种毫米波雷达点云信息和摄像头视觉信息融合的算法。算法首先使用设计的最近邻帧匹配算法,实现数据帧对齐。其次,对于毫米波雷达点云稀疏的问题,提出了点云膨胀算法,增强毫米波雷达的特征表达。之后,对现有融合网络进行了改进,提出增强中心融合网络,加入多模态信息数据级融合,增强毫米波雷达和摄像头的信息交互。

2. 毫米波雷达与摄像头融合简介

2.1. 毫米波雷达

毫米波雷达是工作在毫米波波段探测的雷达,其频率范围为30~300 GHz。其主要通过区分发射波与接收回波,通过飞行时间(Time of Flight, ToF)法获取目标距离信息,并利用多普勒原理获取目标的径向速度信息 [17]。

Figure 1. Millimeter wave radar receives objects velocity

图1. 毫米波雷达获取目标速度

毫米波雷达通常在BEV中提供目标的方位角和径向距离、径向速度以及RCS等信息。如图1所示,毫米波雷达只能获取车辆坐标系中目标的径向速度,切向速度分量则无法获取。

本文所使用的毫米波雷达传感器的输出维度如表1所示。

Table 1. Millimeter wave radar sensor output dimension

表1. 毫米波雷达传感器输出维度

2.2. 摄像头

摄像头通过采集光学图像,为车辆提供视觉信息,是车辆环境感知的核心传感器之一,主要用于目标识别、环境地图构建、车道线检测和目标跟踪等任务。由于其出色的颜色感知能力和较高的角分辨率,为目标分类提供了丰富的语义信息。目前,主要有CCD和CMOS两种传感器的相机,前者在在噪声,

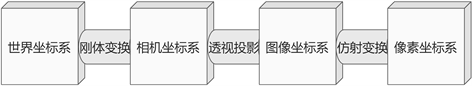

动态范围和复杂环境下的可靠性上更具优势,后者则在牺牲一定性能的条件下降低了成本 [18]。由于单摄像头无法进行三维感知,其信息仅限于二维图像平面。如图2所示,为了从图像信息中获取目标的位置信息,需要进行相机标定,以建立像素坐标系和世界坐标系之间的转换关系。

2.3. 多源信息融合方式

目前常用的毫米波雷达点云信息和摄像头视觉信息数据融合方式包括数据集融合,特征及融合以及决策级融合 [2]。

如图3所示,数据级融合是指点云数据与图像数据在数据输入层进行信息融合,之后,再对融合数据进行特征提取和决策输出。由于神经网络输入包含多模态数据完整信息,因此,数据级融合具有最低的信息损耗率和最高的可靠性。

如图4所示,特征级融合通常分别提取雷达的特征信息和图像的特征信息,并同时输入检测网络,对融合特征进行训练学习,优势在于检测模型可以同时学习多源特征。

如图5所示,决策级融合通常对毫米波雷达和摄像机的检测结果信息进行融合决策,可以兼顾雷达的深度信息以及摄像头的视野和分辨率优势。决策级融合的难点在于建模多源传感器不同模态信息的联合概率密度函数。

3. 一种基于点云膨胀的多模态信息融合算法

基于上述问题,本文提出一种基点云膨胀的毫米波雷达和视觉信息融合算法。算法首先对多源异构信息进行时空对齐,之后,使用点云膨胀算法对毫米波雷达点云数据进行数据增强,采用数据级融合制作毫米波雷达和视觉的联合表征,融合多源异构信息,并使用提出的增强中心融合网络进行检测,生成决策信息。

3.1. 多源异构信息时空对齐

由于雷达点云信息和视觉图像信息无法直接融合,因此,算法首先需要对数据进行时空对齐,保证数据的时空一致性。数据的时空对齐包含时间维度的帧同步以及空间维度的坐标变换。其中,对于帧同步,本文设计了基于最近邻帧匹配算法的帧同步机制,并对其帧匹配误差进行了分析。

3.1.1. 基于最近邻帧匹配算法的帧同步

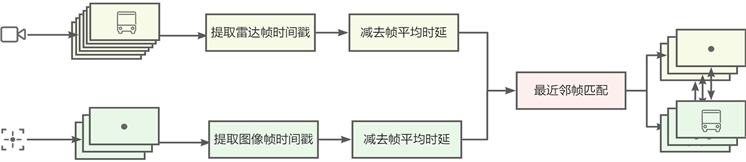

由于不同传感器的时间分辨率差异,多源传感器信息融合首先需要对数据帧进行同步。本文提出基于时间戳的带阈值的最近邻帧匹配算法,对采集的图像帧数据和毫米波雷达点云帧数据进行时间同步。算法流程如图6所示,分别提取雷达帧喝图像帧以及其时间戳,并减去对应的帧平均时延,之后,进行最近邻帧匹配。

Figure 6. Flow chart of frame synchronization of nearest neighbor frame matching algorithm

图6. 最近邻帧匹配算法帧同步流程图

设图像数据帧集合定义为:

(1)

雷达数据帧集合定义为:

(2)

其中,图像数据帧和雷达点云真集合时间戳分别为:

(3)

由于摄像机时钟和毫米波雷达时钟与主机时钟并非完全同步,存在延时。因此,设摄像机时钟与主机时钟平均延时为

,毫米波雷达时钟与主机时钟平均延时为

。

由于图像数据帧率

和毫米波雷达帧率

的差异,选取较低帧率传感器,其帧率记为

,设置帧时差阈值

表示帧同步时间精确度,满足

(4)

使用滑动窗口法对图像帧数据和毫米波雷达帧数据进行融合,生成结果集。

即对于

:

(5)

对于结果集

,其中,每组数据

,都是同步时间误差小于帧时差阈值的数据组。

3.1.2. 多模态数据空间对齐

Figure 7. Spatial coordinate system relation diagram

图7. 空间坐标系关系图

在摄像头的成像系统中,包含世界坐标系、相机坐标系、图像坐标系、像素坐标系这四个坐标系 [19]。如图7所示,世界坐标系与像素坐标系之间的转化关系为:

(6)

其中,

是世界坐标系下某一点的物理坐标,

是映射至像素坐标系下的像素坐标。s是尺度因子。

令矩阵:

(7)

则,称矩阵

为相机的内参矩阵。其中,f为像距,

分别表示

方向上的一个像素在相机感光板上的物理长度,

表示光轴与成像平面的交点坐标,

表示感光板的横边和纵边之间的角度。

令矩阵:

(8)

则,称矩阵

为相机的外参矩阵。其中,R表示旋转矩阵,T表示平移矢量。其值取决于世界坐标系和相机坐标系的相对位置。

此外,由于摄像头这种精密光学器件可能由于内部和外部的一些原因存在着畸变。畸变包括径向畸变和切向畸变,其中,三阶径向畸变公式为:

(9)

三阶切向畸变公式为:

(10)

其中,

为畸变后归一化图像坐标,

为无畸变归一化图像坐标。r为像素到图像中心点距离。

因此,为了避免图像数据源的误差,需要对摄像头的参数进行标定,以获取相机的内参矩阵、外参矩阵以及畸变参数。

3.2. 多源异构信息融合

数据融合首先要将毫米波雷达帧数据和摄像头帧数据经过帧同步后筛选出同步帧数据。然后,再将毫米波雷达帧数据经过滤波和坐标变换后映射至像素坐标系。

由于毫米波雷达点云相较于图像像素具有稀疏的特性,给特征提取造成了困难。因此,本文提出了基于毫米波雷达信息的点云膨胀算法,用来在毫米波雷达数据映射到图像上之后,增强毫米波雷达的特征表达。

3.2.1. 雷达点云坐标变换

Figure 8. Radar and camera coordinate mapping

图8. 雷达和摄像头坐标映射

雷达、摄像头与像素坐标系的映射关系 [20] 如图8所示。

和

分别是毫米波雷达和摄像头的坐标系,

为像素坐标系。

则毫米波雷达和摄像机与像素之间的变换矩阵为:

(11)

其中,

和

分别代表内参矩阵和外参矩阵。

由于毫米波雷达只提供

和

两个坐标方向的值,

值恒为0,因此,可以简化上式为:

(12)

使

,

,

,

,其中,n是雷达点云数。转换矩阵T可以由最小二乘法得出:

(13)

3.2.2. 基于点云膨胀算法的数据增强

摄像头所获得的图像信息由于在恶劣天气环境下缺乏鲁棒性,而毫米波雷达信息可以为这种环境为摄像头提供很好的互补信息 [21]。为了融合多模态信息,算法需要将毫米波雷达信息映射到图像中,便于后续特征学习。

毫米波雷达信息不包含目标语义信息,无法判断目标形态,为了利用毫米波雷达信息,算法使用雷达点云坐标变换,将毫米波雷达点云变换至图像坐标系,并且增加图像通道,将雷达通道目标RCS信息

,和距离信息d以及速度信息的正交分量

投影至像素坐标系中,反应为目标的大小。这样可以让网络在获得雷达信息的同时,不丢失图像的语义信息。

由于毫米波雷达点云具有稀疏的特性,因此使用点云膨胀算法,对雷达点云信息进行膨胀,以增强其在后续目标检测中的特征表达。对毫米波雷达点云信息在图像坐标系的W、H和T三个维度进行膨胀。在T维度的膨胀实现上采用多帧毫米波雷达点云图像进行数据增强,在W和H维度上的膨胀实现上采用在像素平面膨胀目标的宽和高。

如图9所示为毫米波雷达点云膨胀前后的效果。由于点云膨胀前后的x维度中心点未发生变化,因此保留的毫米波雷达的角度信息。而点云膨胀后的长宽反映了目标的深度信息。

3.2.3. 增强的中心融合网络ECFN

基于深度学习的纯视觉目标检测网络通常以图像

作为网络输入。其中,W和H分辨是图像的宽和高的像素值。网络输出则为

,其中,R是网络的下采样率,C是目标类别数量。其中,预测值

代表对于在

处存在目标c的概率是p。其中,生成特征图的真实值

由图像数据的标注生成。网络的代价函数通常描述为

,其中,L为损失函数。

中心点网络(CenterNet)是一个基于视觉的目标检测器 [22]。与YOLO,SSD,Faster_RCNN等依靠大量锚点的检测器不同,CenterNet是一种无锚点目标检测网络。CenterNet使用目标中心点来表示目标,并使用中心点的偏移量,宽高来得到物体实际的框。CenterNet使用热图来表示分类信息,每一个类别对应一张热图,使用高斯圆来表示关键点,热图中的高斯圆代表坐标处有目标的中心点。

(14)

CenterNet的损失函数包含三部分,其中,

代表热图的损失,

代表目标长宽预测的损失,

代表中心点偏移值的损失。

,

分别代表长宽损失和中心点偏移损失的权重。

对于热图损失的计算公式

,表示为:

(15)

其中,

和

是用来均衡难易样本和正负样本的超参数,N是图像关键点数量。求和下标

表示热图上的所有坐标点,其中,c是目标类别也就是热图数量,

是热图长宽。

是预测值,Y是真实值。

对于目标长宽预测损失

,表示为:

(16)

其中,

表示预测的偏移值,p为图片中目标中心点坐标,R为缩放尺度,

为缩放后中心点的近似整数坐标。

(17)

其中,

为预测尺寸,

为真实尺寸。

针对多模态传感器数据源,中心融合网络(CenterFusion) [23] 基于CenterNet提出了一种特征级的融合算法。算法通过图像创建候选框,并利用相关联的雷达点云信息来调整预测。

CenterFusion使用CenterNet来预测目标的中心点和目标的3D边界框。首先,使用改进的深层聚合网络(Deep Layer Aggregation, DLA)作为主干网进行图像特征提取。然后,将提取的特征用于预测目标中心点,以及目标框。

在CenterNet基础上,需要将雷达点云信息与图像相关联。CenterFusion使用目标的2D边界框以及其深度来创建3D的ROI,并筛选出目标ROI中的雷达点云数据。由于ROI中可能存在多个点云,CenterFusion将最近的点云信息作为输入,并与图像目标相关联,以辅助检测网络的训练。

CenterFusion相比基于相机的算法显著提升了精度。但是,CenterFusion存在以下问题:

1、CenterFusion仅使用雷达模态信息进行辅助训练,以改善相机的检测效果。辅助网络只选取ROI区域内最近的点云信息对图像候选框进行辅助训练,对雷达点云信息利用不充分,可能在恶劣天气下存在着性能衰减的问题。

2、CenterFusion未充分利用雷达点云的rcs等通道信息。

针对以上问题,本文对CenterFusion进行改进,使用改进后的增强中心融合网络(Enhance CenterFusion Net, ECFN)进行目标检测。

如图10所示,为了融合毫米波雷达感知信息,ECFN首先对毫米波雷达和摄像头帧信息进行时空对齐。毫米波雷达信息被映射到图像上,表示为新增的通道。与摄像机获取的视觉信号相比,毫米波雷达点云数据非常稀疏。为了加强雷达信号在网络中的特征表达,ECFN首先采用点云膨胀算法对毫米波雷达点云信号进行雷达通道数据增强。

为了融合多通道信息,以便于后续的特征学习,ECFN以

为输入,其中,

为毫米波雷达信息通道数。受Inception网络 [24] 中1 × 1卷积核降维的方法启发,ECFN在网络检测头处使用3个

卷积核降维。1 × 1卷积核最早出现在Network In Network [25] 中,用来加深加宽网络结构。后续在Inception中,使用1 × 1卷积核在降低大量运算的前提下,降低了特征维度。ECFN使用3个

卷积核进行通道压缩,降低特征维度。

ECFN对CenterFusion的损失函数进行了改进,引入毫米波雷达的信息。单依赖视觉图像信息无法对目标速度预测,毫米波雷达可以依赖多普勒效应检测目标径向速度信息。目标速度的预测值

,

是雷达点云信息中速度的维度。ECFN采用速度的L1正则损失作为损失函数,表示为:

(18)

其中,

是目标的实际速度。

对于目标深度信息,其预测值

,ECFN采用深度的L2正则损失作为损失函数,表示为:

(19)

其中,

是目标的实际深度。

则最终损失函数为:

(20)

其中,

,

分别代表速度损失和深度损失的权重,由于目标深度信息与坐标信息不独立,因此

取较小值。

4. 融合结果与分析

本文对所提算法在如表2所示硬件设备上进行实验,并分析帧同步算法误差和召回率,以及对摄像机标定结果的展示,并对本文所提多源异构信息融合网络ECFN进行测试分析。

4.1. 多源异构融合实验环境

本文所涉及硬件型号及其制造商如表2所示。

Table 2. Hardware equipment and manufacturer

表2. 硬件设备及制造商

本文所涉及相关环境版本信息如表3所示。

Table 3. Relevant environment information

表3. 相关环境版本信息

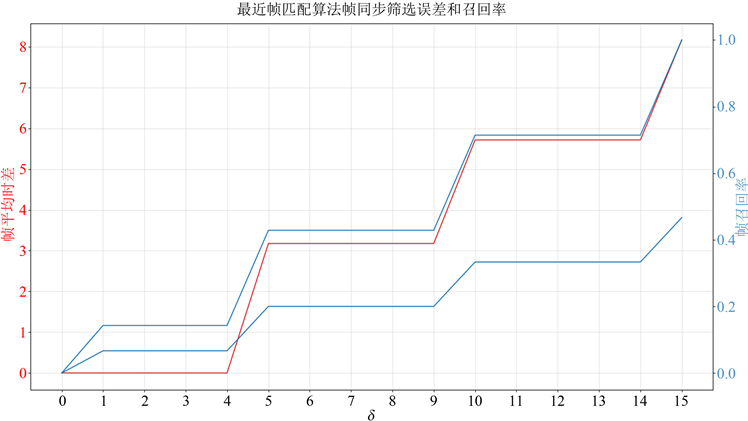

Figure 11. Frame matching algorithm frame synchronization filtering error and recall rate

图11. 帧匹配算法帧同步筛选误差和召回率

4.2. 最近邻帧匹配算法帧同步分析

采用帧率为30 fps的摄像头和帧率为14 fps的毫米波雷对本文所提出的最近邻帧匹配算法进行测试分析。同步筛选后的误差和召回率如图11所示。

随着最大帧时差

的增加,摄像头数据帧和毫米波雷达数据帧召回率都随之增大,但是与此同时,帧平均时差也随之上升。本实验最大帧时差选择10 ms,此时,帧平均时差小于6 ms,且毫米波雷达帧召回率大于55%。

4.3. 摄像机标定结果分析

本文采用张正友标定法对相机进行标定。如图12所示,使用6 × 4大小棋盘格,并使其在摄像头视野范围内的不同位置进行拍摄,得到一组图像。如图13所示,对图像中的特征点如标定板角点进行检测,得到标定板角点的像素坐标值,根据已知的棋盘格大小和世界坐标系原点,计算得到标定板角点的物理坐标值。并求解得内参矩阵、外参矩阵和畸变参数矩阵。

如图13所示为相机标定校正前(左)和相机标定校正后(右)的拍摄结果。

4.4. EFCN检测结果分析

采用公开数据集纽森(nuScenes) [26] 对算法现有融合算法CenterFusion和本文提出的融合算法ECFN进行测试。

测试指标的平均精度(Average Precision, AP)的阈值匹配使用地面上的2D中心距离d。全类平均正确率(mean Average Precision, mAP)类似于2D目标检测中的AP度量,但匹配策略被从IoU替换为BEV平面上的2D中心距离。如式21所示,mAP是通过平均分类

以及

这四种不同距离阈值下的AP来计算的。

(21)

对于所有真阳性(TruePositive,TP)度量,使用

的中心距离计算。度量标准如表4所示。

对于每一个TP度量,使用公式22计算其全类平均真阳性率(mean True Positive, mTP)。

(22)

纽森检测分数(nuScenes Detection Score,NDS)是几个指标的组合,其计算方式如式23所示:

(23)

其中,

是五个mTP度量的集合。通过mAP度量和mTP度量的加权和来计算NDS。mAP的权重为5,其余mTP度量的权重为1。

使用CenterFusion对nuScenes数据集的测试集进行测试,结果如表5所示。

Table 5. The existing fusion algorithm CenterFusion test results

表5. 现有融合算法CenterFusion测试结果

使用本文提出网络ECFN对nuScenes数据集的测试集进行测试,结果如表6所示。

Table 6. The proposed algorithm ECFN test results

表6. 本文算法ECFN测试结果

现有算法CenterFusion以及本文改进算法ECFN的mAP及NDS分数结果如表7所示。

Table 7. Comparison of test results between the proposed algorithm ECFN and the existing fusion algorithm CenterFusion

表7. 本文算法ECFN与现有融合算法CenterFusion测试结果对比

网络的平均推理时间如表8所示。

Table 8. Comparison of running time between the proposed algorithm ECFN and the existing fusion algorithm CenterFusion

表8. 本文算法ECFN与现有融合算法CenterFusion运行时间对比

测试结果表明,本文提出的基于摄像头和雷达的信息融合算法ECFN在公开数据集nuScenes上相较于现有融合算法CenterFusion,在时间耗费增长2.7%的情况下,mAP提升了0.52%,NDS提升了4.9%。

基金项目

本文受国家科技重大专项资助(项目编号:2017ZX05005001-005)。

参考文献